Khung pháp lý cho AI Agent: Hiện tại và tương lai

1. Giới thiệu

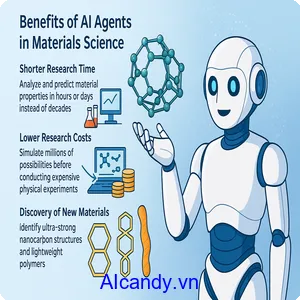

Trong kỷ nguyên số hóa hiện nay, AI Agent đang dần trở thành một phần không thể thiếu trong cuộc sống hàng ngày và hoạt động kinh doanh của chúng ta. Từ trợ lý ảo như Claude, ChatGPT đến các hệ thống tự động hóa phức tạp trong sản xuất, AI Agent đang mang lại những thay đổi to lớn về cách chúng ta làm việc và tương tác.

Tuy nhiên, sự phát triển nhanh chóng của công nghệ này cũng đặt ra nhiều thách thức pháp lý chưa từng có. Làm thế nào để xác định trách nhiệm khi một AI Agent gây ra thiệt hại? Ai sở hữu dữ liệu và trí tuệ được tạo ra bởi AI? Làm thế nào để đảm bảo AI hoạt động công bằng, minh bạch và tôn trọng quyền riêng tư? Bài viết này sẽ phân tích khung pháp lý hiện tại đang điều chỉnh AI Agent, những khoảng trống pháp lý đáng chú ý, các xu hướng pháp lý mới nổi, và đề xuất những phương hướng phát triển trong tương lai để đảm bảo AI Agent có thể phát triển một cách an toàn, có trách nhiệm và mang lại lợi ích cho toàn xã hội.

2. Hiện trạng pháp lý về AI Agent trên thế giới

Hiện nay, khung pháp lý điều chỉnh AI Agent vẫn đang trong giai đoạn phát triển và có sự khác biệt đáng kể giữa các quốc gia.

Tại Liên minh Châu Âu:

Đạo luật AI (AI Act) được thông qua vào đầu năm 2024 đã thiết lập một hệ thống phân loại rủi ro và yêu cầu tuân thủ tương ứng cho các hệ thống AI. Đạo luật này phân chia AI thành bốn mức độ rủi ro: không thể chấp nhận, cao, hạn chế và tối thiểu, với các quy định nghiêm ngặt nhất áp dụng cho AI có rủi ro cao như hệ thống nhận dạng sinh trắc học hoặc AI đánh giá tín dụng.

Tại Hoa Kỳ:

Cách tiếp cận pháp lý về AI Agent khá phân tán với các quy định được ban hành ở cả cấp liên bang và tiểu bang. Sắc lệnh Hành pháp về AI An toàn và Đáng tin cậy (Executive Order on Safe and Trustworthy AI) được ban hành vào tháng 10/2023 đã đặt ra các tiêu chuẩn và hướng dẫn cho các cơ quan liên bang về việc phát triển và sử dụng AI an toàn. Các quy định cụ thể hơn như Đạo luật Thuật toán Công bằng (Algorithmic Accountability Act) đang được xem xét nhằm yêu cầu các công ty đánh giá tác động của hệ thống AI trước khi triển khai.

Tại Trung Quốc:

Ban hành Quy định Quản lý Thuật toán (Algorithm Management Regulations) vào năm 2022, tập trung vào việc kiểm soát cách thức hoạt động của các thuật toán AI ảnh hưởng đến người dùng internet. Đáng chú ý, Trung Quốc cũng đã áp dụng quy định riêng cho AI tạo sinh (Generative AI) vào tháng 8/2023, yêu cầu việc đánh giá nội dung trước khi phát hành và tuân thủ các giá trị cốt lõi của xã hội.

Ví dụ điển hình về thách thức pháp lý hiện nay là vụ kiện giữa các tác giả văn học và OpenAI, trong đó các tác giả cáo buộc rằng việc sử dụng tác phẩm có bản quyền để huấn luyện ChatGPT đã vi phạm quyền sở hữu trí tuệ của họ. Vụ kiện này cho thấy sự cần thiết phải làm rõ ranh giới giữa “sử dụng hợp lý” và vi phạm bản quyền trong bối cảnh AI.

3. Khoảng trống pháp lý và thách thức trong quản lý AI Agent

Mặc dù đã có những nỗ lực đáng kể trong việc xây dựng khung pháp lý cho AI Agent, vẫn còn nhiều khoảng trống và thách thức đáng chú ý.

Vấn đề thứ nhât:

Trách nhiệm pháp lý khi AI Agent gây ra thiệt hại vẫn chưa được giải quyết triệt để. Ai sẽ chịu trách nhiệm khi một xe tự lái gây ra tai nạn? Nhà sản xuất, nhà phát triển phần mềm, chủ sở hữu hay chính bản thân AI? Khung pháp lý hiện tại về trách nhiệm sản phẩm chưa bao quát hết được tính phức tạp của các hệ thống AI có khả năng học hỏi và đưa ra quyết định độc lập.

Vấn đề thứ hai:

Quyền sở hữu trí tuệ đối với nội dung do AI tạo ra vẫn là một vấn đề gây tranh cãi. Tại nhiều quốc gia như Mỹ, tòa án đã từ chối cấp bản quyền cho tác phẩm do AI tạo ra với lý do thiếu yếu tố sáng tạo của con người. Tuy nhiên, ranh giới giữa nội dung do con người tạo ra và nội dung do AI hỗ trợ tạo ra ngày càng mờ nhạt, đặt ra thách thức cho hệ thống sở hữu trí tuệ truyền thống.

Vấn đề thứ ba:

Vviệc đảm bảo tính minh bạch và khả năng giải thích của các thuật toán AI phức tạp là một thách thức lớn. Nhiều hệ thống AI hiện đại, đặc biệt là các mô hình học sâu, hoạt động như “hộp đen” mà ngay cả nhà phát triển cũng khó có thể giải thích chính xác cách thức AI đi đến một quyết định cụ thể. Điều này gây khó khăn cho việc đánh giá công bằng và trách nhiệm giải trình, đặc biệt trong các lĩnh vực nhạy cảm như y tế hoặc tư pháp.

Vấn đề thứ tư:

Vấn đề riêng tư dữ liệu cũng đặt ra nhiều thách thức khi AI Agent thường cần truy cập và xử lý một lượng lớn dữ liệu cá nhân để hoạt động hiệu quả. Ví dụ điển hình là vụ việc năm 2023 khi Privacy Commissioner của Canada điều tra ứng dụng FaceApp vì thu thập và xử lý dữ liệu sinh trắc học mà không có sự đồng ý đầy đủ từ người dùng.

4. Xu hướng pháp lý mới trong quản lý AI Agent

Đối mặt với những thách thức nêu trên, nhiều xu hướng pháp lý mới đang hình thành để điều chỉnh hoạt động của AI Agent một cách hiệu quả hơn.

Xu hướng đầu tiên:

Phương pháp tiếp cận dựa trên rủi ro (risk-based approach) đang được nhiều quốc gia và khu vực áp dụng. EU AI Act là ví dụ điển hình cho xu hướng này, khi áp đặt các yêu cầu nghiêm ngặt hơn đối với các hệ thống AI có rủi ro cao, trong khi áp dụng quy định nhẹ nhàng hơn cho các ứng dụng có rủi ro thấp hơn.

Xu hướng thứ hai:

Yêu cầu về tính minh bạch thuật toán và khả năng giải thích (algorithmic transparency and explainability). Nhiều quy định mới yêu cầu các nhà phát triển phải có khả năng giải thích cách thức AI đưa ra quyết định, đặc biệt trong các lĩnh vực nhạy cảm. Ví dụ, Đạo luật Minh bạch Thuật toán (Algorithmic Transparency Act) được đề xuất tại Mỹ yêu cầu các công ty công khai thông tin về cách thức hoạt động của các thuật toán có ảnh hưởng đáng kể đến người dùng.

Xu hướng thứ ba:

Khái niệm “AI Ethics by Design” đang được tích hợp vào các yêu cầu pháp lý. Điều này đòi hỏi các nhà phát triển phải xem xét các vấn đề đạo đức ngay từ giai đoạn thiết kế AI, không chỉ như một yếu tố bổ sung sau này. Singapore đã ban hành Khung AI Quản trị Tự nguyện (Voluntary AI Governance Framework) vào năm 2022, khuyến khích các doanh nghiệp áp dụng các nguyên tắc đạo đức trong quá trình phát triển AI.

Xu hướng thứ tư:

Việc sử dụng các công cụ “sandbox” pháp lý, cho phép thử nghiệm các công nghệ AI mới trong một môi trường có kiểm soát với các quy định tạm thời. Cơ quan Quản lý Tài chính Anh (UK Financial Conduct Authority) đã triển khai sandbox cho các ứng dụng fintech sử dụng AI, cho phép các công ty thử nghiệm sản phẩm mới trong một môi trường an toàn mà không phải lo ngại về việc vi phạm quy định.

5. Đề xuất phát triển pháp lý trong tương lai

Để xây dựng một khung pháp lý hiệu quả cho AI Agent trong tương lai, các nhà làm luật cần cân nhắc một số hướng tiếp cận quan trọng.

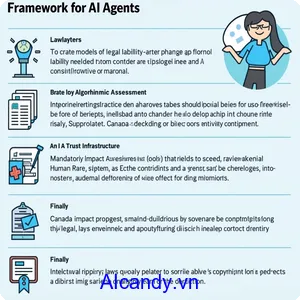

Hướng tiếp cận thứ nhất:

Cần xây dựng mô hình trách nhiệm pháp lý mới phù hợp với đặc thù của AI Agent. Một số chuyên gia đề xuất mô hình “trách nhiệm phân tầng” (layered liability), trong đó trách nhiệm được phân bổ giữa các bên liên quan như nhà phát triển, nhà cung cấp và người sử dụng tùy thuộc vào mức độ kiểm soát và khả năng dự đoán hậu quả của mỗi bên.

Hướng tiếp cận thứ hai:

Cần thiết lập các yêu cầu bắt buộc về đánh giá tác động thuật toán (Algorithmic Impact Assessment) trước khi triển khai các hệ thống AI có rủi ro cao. Những đánh giá này nên bao gồm việc xem xét các tác động tiềm ẩn về quyền con người, công bằng xã hội và tác động môi trường. Canada đã tiên phong trong việc áp dụng Đánh giá Tác động Thuật toán bắt buộc cho các cơ quan chính phủ khi triển khai các hệ thống quyết định tự động.

Hướng tiếp cận thứ ba:

Cần phát triển khung pháp lý cho “AI Trust Infrastructure”, bao gồm các tiêu chuẩn kỹ thuật và quy trình chứng nhận để đảm bảo AI Agent đáp ứng các yêu cầu về an toàn, bảo mật và đạo đức. Ví dụ, việc thiết lập các cơ quan chứng nhận độc lập có thể giúp xác minh rằng các hệ thống AI tuân thủ các tiêu chuẩn đã được thiết lập trước khi đưa ra thị trường.

Hướng tiếp cận thứ tư:

Cần cập nhật luật sở hữu trí tuệ để giải quyết vấn đề quyền sở hữu đối với nội dung do AI tạo ra. Một số quốc gia đang xem xét việc công nhận quyền sở hữu trí tuệ cho “sáng tạo có sự hỗ trợ của AI” (AI-assisted creations) trong khi vẫn phân biệt với nội dung hoàn toàn do AI tạo ra. Nhật Bản đã điều chỉnh luật bản quyền để cho phép khai thác dữ liệu có bản quyền cho mục đích huấn luyện AI, đây có thể là một mô hình tham khảo cho các quốc gia khác.

6. Kết luận

Khung pháp lý cho AI Agent đang đối mặt với thách thức kép: vừa phải đủ linh hoạt để không cản trở sự đổi mới công nghệ, vừa phải đủ mạnh mẽ để bảo vệ xã hội khỏi các rủi ro tiềm ẩn. Sự phát triển nhanh chóng của công nghệ AI đòi hỏi các nhà hoạch định chính sách phải liên tục cập nhật và điều chỉnh cách tiếp cận pháp lý của họ.

Để xây dựng một khung pháp lý hiệu quả trong tương lai, cần có sự hợp tác chặt chẽ giữa các nhà hoạch định chính sách, chuyên gia kỹ thuật, doanh nghiệp và xã hội dân sự. Các quy định cần được xây dựng dựa trên bằng chứng và phải đủ linh hoạt để thích ứng với những tiến bộ công nghệ mới.