PyTorch trong học máy cho người mới bắt đầu

1. Giới thiệu

Trong những năm gần đây, học máy đã trở thành một lĩnh vực quan trọng và phát triển nhanh chóng trong trí tuệ nhân tạo. Để xây dựng và triển khai các mô hình học máy hiệu quả, việc lựa chọn một framework phù hợp là vô cùng quan trọng. PyTorch, được phát triển bởi Facebook’s AI Research lab (FAIR), đã nổi lên như một trong những công cụ mạnh mẽ và linh hoạt nhất cho cả nghiên cứu và ứng dụng thực tiễn. Bài viết này sẽ cung cấp một hướng dẫn toàn diện về PyTorch dành cho người mới bắt đầu, giúp bạn hiểu và áp dụng các khái niệm cơ bản trong học máy một cách hiệu quả.

1.1. PyTorch là gì?

PyTorch là một thư viện mã nguồn mở dành cho học máy dựa trên Python, được sử dụng rộng rãi trong việc phát triển và triển khai các mô hình học sâu. Với cấu trúc linh hoạt và dễ sử dụng, PyTorch cho phép các nhà nghiên cứu và lập trình viên tạo ra các mô hình phức tạp một cách nhanh chóng và hiệu quả.

1.2. Tại sao chọn PyTorch cho học máy?

– Dễ sử dụng và linh hoạt: PyTorch có cú pháp gần gũi với Python, giúp việc viết và hiểu code trở nên dễ dàng hơn. Khả năng linh hoạt trong việc xây dựng và tùy chỉnh mô hình giúp PyTorch phù hợp với nhiều loại dự án khác nhau.

– Tính toán động (Dynamic Computation Graphs): Khác với một số framework khác, PyTorch sử dụng đồ thị tính toán động, cho phép thay đổi cấu trúc của mạng trong quá trình chạy. Điều này đặc biệt hữu ích khi làm việc với các mô hình phức tạp và dữ liệu không đồng nhất.

– Hỗ trợ GPU mạnh mẽ: PyTorch tích hợp tốt với GPU, giúp tăng tốc quá trình huấn luyện và triển khai mô hình.

– Cộng đồng và tài liệu phong phú: PyTorch có một cộng đồng người dùng lớn và tài liệu hỗ trợ đầy đủ, giúp việc học tập và giải quyết vấn đề trở nên dễ dàng hơn.

– Tích hợp với các công cụ khác: PyTorch dễ dàng tích hợp với các thư viện và công cụ khác như NumPy, SciPy, và scikit-learn, mở rộng khả năng và ứng dụng của nó trong nhiều lĩnh vực.

Với những ưu điểm trên, PyTorch đã trở thành lựa chọn hàng đầu cho cả người mới bắt đầu và các chuyên gia trong lĩnh vực học máy và học sâu.

2. Cài đặt PyTorch

Trước khi bắt đầu làm việc với PyTorch, chúng ta cần đảm bảo môi trường hệ thống phù hợp và thực hiện cài đặt đúng cách.

2.1. Yêu cầu hệ thống

Để cài đặt và chạy PyTorch một cách hiệu quả, hệ thống của bạn cần đáp ứng các yêu cầu sau:

– Hệ điều hành: PyTorch hỗ trợ Windows, Linux và macOS.

– Python: Nên sử dụng phiên bản Python 3.6 trở lên.

– Trình quản lý gói: Sử dụng `pip` hoặc `conda` để cài đặt.

– CUDA (tùy chọn): Nếu bạn muốn sử dụng GPU để tăng tốc quá trình tính toán, cần cài đặt CUDA của NVIDIA. Phiên bản CUDA tương thích sẽ phụ thuộc vào phiên bản PyTorch bạn muốn cài đặt.

2.2. Thực hiện cài đặt

Dưới đây là hướng dẫn cài đặt PyTorch bằng `pip` và `conda`.

Cách 1: Cài đặt bằng pip

Cài đặt Python và pip: Nếu bạn chưa có, hãy tải và cài đặt Python từ [python.org](https://www.python.org/downloads/). Tải và cài đặt pip từ pip.pypa.io (https://pip.pypa.io/en/stable/installation/).

Tạo môi trường ảo (khuyến nghị):

python -m venv myenv

source myenv/bin/activate # Trên Linux/Mac

myenv\Scripts\activate # Trên Windows

Cài đặt PyTorch:

– Không sử dụng GPU:

pip install torch torchvision torchaudio

– Sử dụng GPU với CUDA:

Xác định phiên bản CUDA phù hợp và chạy lệnh:

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu118

(Thay `cu118` bằng phiên bản CUDA của bạn, ví dụ: `cu116`)

Cài đặt bằng conda

Cài đặt Anaconda hoặc Miniconda: Tải và cài đặt từ [anaconda.com](https://www.anaconda.com/products/distribution) hoặc [miniconda](https://docs.conda.io/en/latest/miniconda.html).

Tạo môi trường mới:

conda create -n myenv python=3.8

conda activate myenv

Cài đặt PyTorch:

– Không sử dụng GPU:

conda install pytorch torchvision torchaudio cpuonly -c pytorch

– Sử dụng GPU với CUDA:

conda install pytorch torchvision torchaudio cudatoolkit=11.8 -c pytorch -c nvidia

(Thay `cudatoolkit=11.8` bằng phiên bản CUDA tương ứng)

Kiểm tra cài đặt

Sau khi cài đặt, hãy kiểm tra xem PyTorch đã được cài đặt đúng cách chưa:

import torch

print(torch.__version__)

print(torch.cuda.is_available()) # Kiểm tra GPU

Nếu kết quả trả về phiên bản PyTorch và `True` cho GPU (nếu có), bạn đã cài đặt thành công PyTorch và sẵn sàng để bắt đầu.

3. Khái niệm cơ bản trong PyTorch

Để làm việc hiệu quả với PyTorch, chúng ta cần hiểu rõ các khái niệm và thành phần cơ bản sau đây.

3.1. Tensors: Nền tảng của PyTorch

Tensors là gì?

Tensor là một cấu trúc dữ liệu cơ bản trong PyTorch, tương tự như mảng (array) trong NumPy nhưng được thiết kế để chạy hiệu quả trên cả CPU và GPU. Tensor có thể có nhiều chiều, từ scalar (0 chiều) đến tensor nhiều chiều.

3.2. Tạo và thao tác với Tensors

Tạo tensor từ dữ liệu

import torch

# Tạo tensor từ list

data = [[1, 2], [3, 4]]

x_data = torch.tensor(data)

Tạo tensor ngẫu nhiên

# Tensor với giá trị ngẫu nhiên

rand_tensor = torch.rand(2, 3)

# Tensor với giá trị bằng 0

zero_tensor = torch.zeros(2, 3)

# Tensor với giá trị bằng 1

one_tensor = torch.ones(2, 3)

Các thao tác cơ bản

# Cộng hai tensor

y1 = x_data + x_data

# Nhân hai tensor

y2 = x_data * x_data

# Ma trận nhân

y3 = x_data @ x_data.T

Chuyển tensor sang GPU

if torch.cuda.is_available():

x_data = x_data.to('cuda')

3.2. Autograd: Tự động tính toán gradient

Autograd là gì?

`autograd` là một tính năng mạnh mẽ trong PyTorch cho phép tự động tính toán gradient của các tensor. Điều này đặc biệt hữu ích trong việc huấn luyện mô hình học sâu bằng cách tự động hóa quá trình lan truyền ngược (backpropagation).

Sử dụng Autograd

Khai báo tensor với gradient

x = torch.ones(2, 2, requires_grad=True)

Thực hiện các phép tính

y = x + 2

z = y * y * 3

out = z.mean()

Tính toán gradient

out.backward()

print(x.grad)

Tắt tính toán gradient (trong quá trình đánh giá mô hình)

with torch.no_grad():

y = x * 2

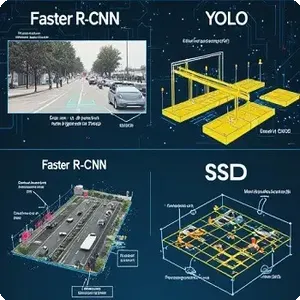

3.3. Neural Networks: Xây dựng mạng nơ-ron với nn.Module

Giới thiệu về nn.Module

`torch.nn` là một module trong PyTorch cung cấp các công cụ để xây dựng và huấn luyện các mô hình học sâu. `nn.Module` là lớp cơ bản cho tất cả các mô hình mạng nơ-ron trong PyTorch.

Xây dựng mô hình đơn giản

Ví dụ: Mạng Perceptron đơn giản

import torch.nn as nn

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.linear = nn.Linear(10, 1)

def forward(self, x):

out = self.linear(x)

return out

model = SimpleNN()

Sử dụng mô hình

input = torch.randn(1, 10)

output = model(input)

print(output)

Các lớp phổ biến trong nn.Module

– nn.Linear: Lớp kết nối đầy đủ (fully connected).

– nn.Conv2d: Lớp tích chập 2D.

– nn.ReLU: Hàm kích hoạt ReLU.

– nn.Softmax: Hàm kích hoạt Softmax.

– nn.Sequential: Kết hợp các lớp theo thứ tự.

Ví dụ: Mạng phân loại hình ảnh đơn giản

class ImageClassifier(nn.Module):

def __init__(self):

super(ImageClassifier, self).__init__()

self.model = nn.Sequential(

nn.Conv2d(3, 16, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(2, 2),

nn.Flatten(),

nn.Linear(16 * 16 * 16, 10),

nn.Softmax(dim=1)

)

def forward(self, x):

return self.model(x)

model = ImageClassifier()

Với hiểu biết về Tensors, Autograd và cách xây dựng mạng nơ-ron bằng `nn.Module`, bạn đã có nền tảng vững chắc để bắt đầu xây dựng và huấn luyện các mô hình học máy với PyTorch.

4. Xử lý dữ liệu với PyTorch

Trong học máy, dữ liệu đóng vai trò quan trọng và việc xử lý dữ liệu một cách hiệu quả là bước không thể thiếu. PyTorch cung cấp các công cụ mạnh mẽ để tải và xử lý dữ liệu thông qua `Dataset` và `DataLoader`.

4.1. Dataset và DataLoader

Dataset

torch.utils.data.Dataset là một lớp trừu tượng đại diện cho tập dữ liệu. Bạn có thể tạo một lớp kế thừa từ `Dataset` và triển khai các phương thức để truy cập dữ liệu của bạn.

Ví dụ: Tạo một Dataset tùy chỉnh

import torch

from torch.utils.data import Dataset

class CustomDataset(Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __len__(self):

return len(self.labels)

def __getitem__(self, idx):

x = self.data[idx]

y = self.labels[idx]

return x, y

# Dữ liệu mẫu

data = torch.randn(100, 10)

labels = torch.randint(0, 2, (100,))

dataset = CustomDataset(data, labels)

DataLoader

`torch.utils.data.DataLoader` cung cấp một cách thuận tiện để lặp qua tập dữ liệu, hỗ trợ chia batch, xáo trộn dữ liệu và sử dụng đa luồng để tăng tốc độ tải dữ liệu.

Sử dụng DataLoader

from torch.utils.data import DataLoader

dataloader = DataLoader(dataset, batch_size=16, shuffle=True, num_workers=2)

for batch_data, batch_labels in dataloader:

# Huấn luyện mô hình với batch_data và batch_labels

pass

Sử dụng các Dataset có sẵn

PyTorch cung cấp nhiều tập dữ liệu phổ biến thông qua `torchvision.datasets`.

Ví dụ: Sử dụng MNIST dataset

import torchvision

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

mnist_train = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

mnist_test = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

train_loader = DataLoader(mnist_train, batch_size=64, shuffle=True)

test_loader = DataLoader(mnist_test, batch_size=64, shuffle=False)

4.2. Biến đổi dữ liệu với torchvision.transforms

torchvision.transforms cung cấp các công cụ để biến đổi và tiền xử lý dữ liệu hình ảnh.

Các biến đổi phổ biến

– transforms.ToTensor(): Chuyển đổi hình ảnh PIL hoặc NumPy array thành tensor.

– transforms.Normalize(mean, std): Chuẩn hóa tensor hình ảnh với giá trị trung bình và độ lệch chuẩn.

– transforms.Resize(size): Thay đổi kích thước hình ảnh.

– transforms.RandomCrop(size): Cắt ngẫu nhiên một phần của hình ảnh.

– transforms.RandomHorizontalFlip(): Lật ngang hình ảnh một cách ngẫu nhiên.

Ví dụ: Chuẩn bị chuỗi biến đổi cho dữ liệu hình ảnh

transform = transforms.Compose([

transforms.Resize((64, 64)),

transforms.RandomHorizontalFlip(),

transforms.ToTensor(),

transforms.Normalize(mean=[0.5, 0.5, 0.5],

std=[0.5, 0.5, 0.5])

])

Áp dụng biến đổi cho Dataset

dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

dataloader = DataLoader(dataset, batch_size=32, shuffle=True)

Tạo biến đổi tùy chỉnh

Bạn cũng có thể tạo các biến đổi tùy chỉnh bằng cách kế thừa từ `torchvision.transforms` hoặc sử dụng các hàm lambda.

Ví dụ: Biến đổi chuyển ảnh sang grayscale

class ToGrayScale:

def __call__(self, sample):

image = sample.convert('L')

return image

transform = transforms.Compose([

ToGrayScale(),

transforms.ToTensor()

])

Với hiểu biết về `Dataset`, `DataLoader` và `transforms`, bạn có thể dễ dàng tải, tiền xử lý và quản lý dữ liệu cho các dự án học máy của mình, đảm bảo quá trình huấn luyện diễn ra hiệu quả và thuận lợi.

5. Xây dựng mô hình học máy đơn giản

Trong phần này, chúng ta sẽ áp dụng những kiến thức đã học để xây dựng, huấn luyện và đánh giá một mô hình học máy đơn giản sử dụng PyTorch.

5.1. Định nghĩa mô hình

Chúng ta sẽ xây dựng một mô hình mạng nơ-ron đơn giản để phân loại ảnh từ tập dữ liệu MNIST.

Bước 1: Chuẩn bị dữ liệu

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# Biến đổi dữ liệu

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

])

# Tải dữ liệu

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

# Tạo DataLoader

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=1000, shuffle=False)

Bước 2: Định nghĩa mô hình

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.flatten = nn.Flatten()

self.fc1 = nn.Linear(28*28, 128)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.flatten(x)

x = self.relu(self.fc1(x))

x = self.fc2(x)

return x

model = SimpleNet()

5.2. Huấn luyện mô hình

Bước 3: Định nghĩa hàm mất mát và optimizer

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

Bước 4: Vòng lặp huấn luyện

def train(model, device, train_loader, optimizer, criterion, epoch):

model.train()

for batch_idx, (data, target) in enumerate(train_loader):

data, target = data.to(device), target.to(device)

# Reset gradient

optimizer.zero_grad()

# Forward pass

output = model(data)

# Tính loss

loss = criterion(output, target)

# Backward pass

loss.backward()

# Cập nhật weights

optimizer.step()

if batch_idx % 100 == 0:

print(f'Epoch {epoch} [{batch_idx*len(data)}/{len(train_loader.dataset)}] Loss: {loss.item():.6f}')

Bước 5: Huấn luyện qua nhiều epoch

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

num_epochs = 5

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch)

5.3. Đánh giá mô hình

Bước 6: Định nghĩa hàm đánh giá

def test(model, device, test_loader, criterion):

model.eval()

test_loss = 0

correct = 0

with torch.no_grad():

for data, target in test_loader:

data, target = data.to(device), target.to(device)

output = model(data)

test_loss += criterion(output, target).item()

pred = output.argmax(dim=1, keepdim=True)

correct += pred.eq(target.view_as(pred)).sum().item()

test_loss /= len(test_loader.dataset)

print(f'Test set: Average loss: {test_loss:.4f}, Accuracy: {correct}/{len(test_loader.dataset)} ({100. * correct / len(test_loader.dataset):.2f}%)')

Bước 7: Đánh giá mô hình sau huấn luyện

test(model, device, test_loader, criterion)

Kết quả mẫu:

Test set: Average loss: 0.0021, Accuracy: 9780/10000 (97.80%)

Với kết quả trên, chúng ta có thể thấy mô hình đã đạt được độ chính xác khá cao trên tập dữ liệu kiểm tra.

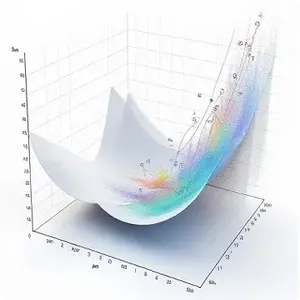

6. Các kỹ thuật tối ưu hóa trong PyTorch

Để cải thiện hiệu suất và tốc độ hội tụ của mô hình, PyTorch cung cấp nhiều kỹ thuật tối ưu hóa như sử dụng các optimizer khác nhau và điều chỉnh learning rate.

6.1. Optimizers

Giới thiệu về Optimizer

Optimizer là thuật toán được sử dụng để cập nhật trọng số của mô hình nhằm giảm thiểu hàm mất mát. PyTorch cung cấp nhiều optimizer khác nhau trong module `torch.optim`.

Các optimizer phổ biến

– SGD (Stochastic Gradient Descent):

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

– Adam:

optimizer = optim.Adam(model.parameters(), lr=0.001)

– RMSprop:

optimizer = optim.RMSprop(model.parameters(), lr=0.001)

So sánh các optimizer

– SGD: Đơn giản và hiệu quả cho nhiều bài toán, nhưng có thể chậm hội tụ.

– Adam: Kết hợp giữa Momentum và RMSprop, thường hội tụ nhanh hơn và phù hợp cho nhiều loại mô hình.

– RMSprop: Tốt cho các bài toán với gradient không ổn định.

Thay đổi optimizer trong mô hình

# Chuyển từ SGD sang Adam

optimizer = optim.Adam(model.parameters(), lr=0.001)

6.2. Learning rate schedulers

Giới thiệu về Learning Rate Scheduler

Learning rate scheduler được sử dụng để điều chỉnh learning rate trong quá trình huấn luyện, giúp mô hình hội tụ tốt hơn và tránh mắc kẹt trong các điểm tối ưu cục bộ.

Các scheduler phổ biến

– StepLR: Giảm learning rate sau mỗi vài epoch.

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.1)

– ReduceLROnPlateau: Giảm learning rate khi metric không cải thiện.

scheduler = optim.lr_scheduler.ReduceLROnPlateau(optimizer, 'min')

– ExponentialLR: Giảm learning rate theo hàm mũ.

scheduler = optim.lr_scheduler.ExponentialLR(optimizer, gamma=0.95)

Sử dụng scheduler trong quá trình huấn luyện

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch)

scheduler.step()

Sử dụng ReduceLROnPlateau

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch)

val_loss = validate(model, device, val_loader, criterion)

scheduler.step(val_loss)

Theo dõi và ghi lại learning rate

Bạn có thể theo dõi learning rate trong quá trình huấn luyện để hiểu rõ hơn về quá trình tối ưu hóa.

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch)

print(f'Current learning rate: {scheduler.get_last_lr()}')

scheduler.step()

Kết hợp optimizer và scheduler

Việc lựa chọn đúng optimizer và scheduler phụ thuộc vào bài toán cụ thể và có thể cần thử nghiệm để tìm ra cấu hình tốt nhất.

Ví dụ kết hợp Adam và StepLR

optimizer = optim.Adam(model.parameters(), lr=0.001)

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=5, gamma=0.5)

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch)

scheduler.step()

Với việc sử dụng các kỹ thuật tối ưu hóa này, bạn có thể cải thiện hiệu suất mô hình, tăng tốc độ hội tụ và đạt được kết quả tốt hơn trong các bài toán học máy.

7. Lưu và tải mô hình

Việc lưu trữ và tải lại mô hình là một phần quan trọng trong quá trình phát triển và triển khai mô hình học máy. PyTorch cung cấp các phương thức đơn giản và hiệu quả để thực hiện điều này.

7.1. Lưu trữ mô hình đã huấn luyện

Có hai cách phổ biến để lưu trữ mô hình trong PyTorch:

Lưu state_dict của mô hình

state_dict là một từ điển chứa tất cả các tham số học được (weights và biases) của mô hình.

Lưu state_dict

torch.save(model.state_dict(), 'model.pth')

Ưu điểm:

– Linh hoạt: Dễ dàng tải vào các mô hình có cấu trúc tương tự.

– Kích thước nhỏ hơn so với lưu toàn bộ mô hình.

Lưu toàn bộ mô hình

torch.save(model, 'model_complete.pth')

Ưu điểm:

– Dễ sử dụng: Bao gồm cả cấu trúc và tham số của mô hình.

– Tiện lợi khi triển khai mô hình mà không cần định nghĩa lại kiến trúc.

Lưu trữ optimizer state_dict

Để tiếp tục quá trình huấn luyện từ điểm dừng, bạn cũng nên lưu state_dict của optimizer.

torch.save({

'epoch': epoch,

'model_state_dict': model.state_dict(),

'optimizer_state_dict': optimizer.state_dict(),

'loss': loss,

}, 'checkpoint.pth')

7.2. Tải mô hình để sử dụng

Tải state_dict vào mô hình

Định nghĩa lại mô hình và tải state_dict

model = SimpleNet()

model.load_state_dict(torch.load('model.pth'))

model.eval() # Đặt mô hình vào chế độ đánh giá

Tải checkpoint

checkpoint = torch.load('checkpoint.pth')

model.load_state_dict(checkpoint['model_state_dict'])

optimizer.load_state_dict(checkpoint['optimizer_state_dict'])

epoch = checkpoint['epoch']

loss = checkpoint['loss']

Tải toàn bộ mô hình

model = torch.load('model_complete.pth')

model.eval()

Sử dụng mô hình đã lưu để dự đoán

Ví dụ: Dự đoán với dữ liệu mới

# Giả sử bạn có một ảnh đầu vào mới

input_image = ... # Tiền xử lý ảnh tương tự như khi huấn luyện

input_tensor = transform(input_image).unsqueeze(0) # Thêm batch dimension

# Dự đoán

with torch.no_grad():

output = model(input_tensor)

predicted_class = output.argmax(dim=1).item()

print(f'Predicted class: {predicted_class}')

Lưu và tải mô hình trên GPU và CPU

Lưu mô hình trên GPU và tải trên CPU

Khi lưu mô hình được huấn luyện trên GPU và muốn tải trên CPU:

Lưu trên GPU

torch.save(model.state_dict(), 'model.pth')

Tải trên CPU

device = torch.device('cpu')

model = SimpleNet()

model.load_state_dict(torch.load('model.pth', map_location=device))

Tải trên GPU

device = torch.device('cuda')

model = SimpleNet().to(device)

model.load_state_dict(torch.load('model.pth'))

Với việc hiểu và áp dụng đúng cách lưu và tải mô hình, bạn có thể dễ dàng quản lý, triển khai và chia sẻ các mô hình học máy của mình một cách hiệu quả và linh hoạt.

8. Kết luận

Trong bài viết này, chúng ta đã đi qua một hướng dẫn toàn diện về các khía cạnh cơ bản của PyTorch, từ cài đặt, hiểu biết về tensors, autograd, xây dựng mô hình mạng nơ-ron, xử lý dữ liệu, huấn luyện, đánh giá, đến các kỹ thuật tối ưu hóa và cách lưu trữ mô hình. Với kiến thức này, bạn đã có một nền tảng vững chắc để bắt đầu hành trình trong lĩnh vực học máy và học sâu bằng PyTorch.

Những điểm chính đã học được:

– PyTorch là một framework mạnh mẽ và linh hoạt cho việc phát triển các mô hình học sâu, với cú pháp thân thiện và hỗ trợ tính toán trên GPU.

– Tensors là nền tảng của PyTorch, cung cấp cấu trúc dữ liệu hiệu quả cho các tính toán số học và ma trận.

– Autograd giúp tự động hóa quá trình tính toán gradient, làm cho việc triển khai các thuật toán học máy trở nên dễ dàng hơn.

– Module nn cung cấp các công cụ để xây dựng các mô hình mạng nơ-ron từ đơn giản đến phức tạp.

– Dataset và DataLoader giúp quản lý và xử lý dữ liệu một cách hiệu quả, hỗ trợ quá trình huấn luyện mô hình.

– Các kỹ thuật tối ưu hóa như sử dụng optimizer và learning rate scheduler cải thiện hiệu suất và tốc độ hội tụ của mô hình.

– Việc lưu trữ và tải mô hình là quan trọng để triển khai và tiếp tục huấn luyện trong tương lai.