Từ điển trí tuệ nhân tạo: Hành trang cho Beginner

1. Cơ bản về trí tuệ nhân tạo

Artificial Intelligence – AI

Artificial Intelligence là lĩnh vực nghiên cứu phát triển các hệ thống máy tính có khả năng thực hiện các nhiệm vụ mà trước đây yêu cầu trí tuệ con người, như nhận dạng giọng nói, nhận dạng hình ảnh, ra quyết định và dịch ngôn ngữ.

Machine Learning – ML

Machine Learning là một nhánh của AI, tập trung vào việc phát triển các thuật toán và mô hình cho phép máy tính học từ dữ liệu mà không cần lập trình rõ ràng. Các ứng dụng phổ biến của học máy bao gồm phân loại, hồi quy, và dự đoán.

Deep Learning – DL

Deep Learning là một phần của học máy, sử dụng các mạng nơ-ron nhân tạo với nhiều lớp (deep neural networks) để mô phỏng cách bộ não con người hoạt động, từ đó giải quyết các bài toán phức tạp như nhận dạng giọng nói và thị giác máy tính.

Natural Language Processing – NLP

Natural Language Processing là lĩnh vực nghiên cứu và phát triển các thuật toán cho phép máy tính hiểu, diễn giải và phản hồi ngôn ngữ tự nhiên của con người. Các ứng dụng của NLP bao gồm chatbot, dịch máy và phân tích cảm xúc.

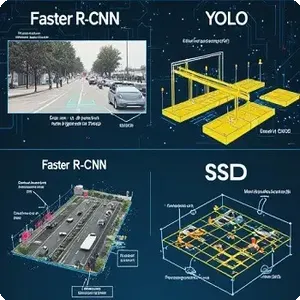

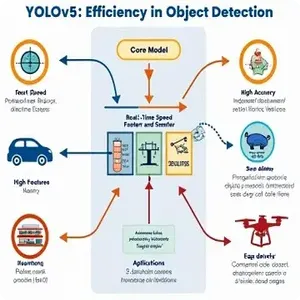

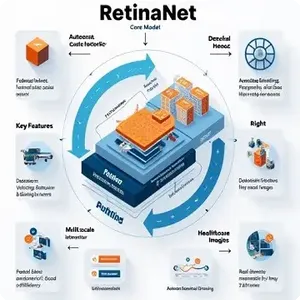

Computer Vision

Computer Vision là lĩnh vực của AI chuyên về việc cho phép máy tính “nhìn thấy” và hiểu được thông tin từ hình ảnh hoặc video. Nó được ứng dụng trong nhiều lĩnh vực như nhận dạng khuôn mặt, xe tự lái, và phân tích video.

Artificial General Intelligence – AGI

Artificial General Intelligence là hình thức AI tiên tiến có khả năng thực hiện bất kỳ nhiệm vụ trí tuệ nào mà con người có thể làm. Mặc dù AGI hiện nay chỉ là một khái niệm lý thuyết, nhưng nó là mục tiêu cuối cùng của nhiều nghiên cứu AI.

Narrow AI

Narrow AI là loại AI được thiết kế để thực hiện một nhiệm vụ cụ thể, chẳng hạn như dự đoán xu hướng mua hàng hoặc nhận dạng khuôn mặt. Đây là dạng AI phổ biến nhất hiện nay.

2. Mô hình và mạng Nơ-ron (Models and Neural Networks)

AI Model

AI Model là sự triển khai của các thuật toán AI, được huấn luyện trên dữ liệu để thực hiện một nhiệm vụ cụ thể, như phân loại hình ảnh hoặc dự đoán xu hướng thị trường.

Artificial Neural Networks – ANN

Artificial Neural Networks là mô hình học máy mô phỏng cách thức hoạt động của bộ não con người, sử dụng các đơn vị tính toán gọi là nơ-ron nhân tạo để truyền và xử lý thông tin.

Neuron (Perceptron)

Là thành phần cơ bản nhất trong một mạng nơ-ron nhân tạo (Artificial Neural Network). Nó hoạt động như một đơn vị tính toán, mô phỏng cách một nơ-ron sinh học xử lý thông tin. Perceptron nhận một hoặc nhiều đầu vào, gán trọng số cho từng đầu vào, cộng chúng lại, thêm bias (nếu có), rồi áp dụng một hàm kích hoạt để tạo ra đầu ra.

Activation Function

Là một hàm toán học được áp dụng cho mỗi neuron trong mạng nơ-ron, quyết định đầu ra của neuron đó dựa trên tổng trọng số của các đầu vào. Hàm kích hoạt giúp mạng học được các mối quan hệ phi tuyến tính, từ đó làm tăng khả năng của mạng trong việc giải quyết các bài toán phức tạp.

Back propagation

Là một thuật toán quan trọng trong quá trình huấn luyện mạng nơ-ron nhân tạo (Artificial Neural Networks – ANN). Nó được sử dụng để tối ưu hóa các trọng số (weights) trong mạng bằng cách cập nhật chúng dựa trên lỗi (loss) mà mô hình tạo ra, qua đó giúp cải thiện hiệu suất của mô hình.

Forward propagation

Là quá trình truyền dữ liệu từ đầu vào qua các lớp trong mạng nơ-ron, tính toán các giá trị đầu ra của từng lớp dựa trên trọng số và hàm kích hoạt. Đây là bước đầu tiên trong quá trình huấn luyện mạng nơ-ron và cũng là bước để mạng nơ-ron tạo ra dự đoán (prediction).

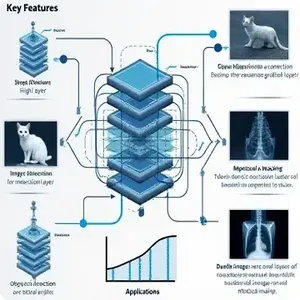

Convolutional Neural Networks – CNN

Convolutional Neural Networks là một loại mạng nơ-ron được thiết kế đặc biệt để xử lý dữ liệu dạng hình ảnh. Nó sử dụng các tầng tích chập (convolutional layers) để tự động phát hiện các đặc trưng trong ảnh.

Convolutional Layer

Là một thành phần cơ bản trong Convolutional Neural Networks (CNN), được sử dụng chủ yếu trong các bài toán xử lý hình ảnh và video, nhưng cũng có thể áp dụng cho các loại dữ liệu khác. Lớp này thực hiện một phép toán tích chập (convolution) giữa đầu vào và các bộ lọc (filters) hoặc kernel, giúp trích xuất các đặc trưng (features) từ dữ liệu.

Kernel/Filter

Là một ma trận nhỏ được sử dụng trong quá trình Convolution (tích chập) trong các Convolutional Neural Networks (CNN). Kernel hay Filter có nhiệm vụ trích xuất các đặc trưng (features) từ đầu vào như hình ảnh, âm thanh hoặc các dữ liệu khác. Mỗi kernel được học trong quá trình huấn luyện của mạng nơ-ron và có nhiệm vụ tìm kiếm các đặc trưng trong dữ liệu đầu vào như các cạnh (edges), góc (corners), kết cấu (textures), và các mẫu phức tạp hơn.

Stride

Là một tham số quan trọng trong quá trình Convolution (tích chập) trong Convolutional Neural Networks (CNN). Stride xác định mức độ di chuyển của kernel (bộ lọc) qua dữ liệu đầu vào trong mỗi lần quét. Nó ảnh hưởng trực tiếp đến kích thước của feature map (bản đồ đặc trưng) đầu ra. Stride thường được sử dụng để kiểm soát kích thước của feature map đầu ra và cũng giúp giảm thiểu số lượng phép toán cần thiết trong mạng nơ-ron.

Padding

Là một kỹ thuật trong Convolutional Neural Networks (CNN) được sử dụng để thêm các giá trị (thường là giá trị 0) vào xung quanh biên của dữ liệu đầu vào, chẳng hạn như ảnh, trước khi áp dụng phép tích chập (convolution). Khi kernel (bộ lọc) quét qua đầu vào, các giá trị ở biên của ảnh có thể không có đủ pixel xung quanh để tính toán với kernel (ví dụ, khi kernel không thể quét hoàn toàn qua một vùng ở góc của ảnh). Padding giúp giữ cho các thông tin ở biên ảnh không bị mất đi.

Pooling Layer

Là một thành phần quan trọng trong Convolutional Neural Networks (CNN), giúp giảm kích thước của dữ liệu đầu vào, từ đó giảm số lượng tham số và độ phức tạp tính toán, đồng thời giữ lại các đặc trưng quan trọng của dữ liệu. Pooling layer giúp giảm độ phân giải của feature map, giúp giảm số lượng phép toán cần thiết trong quá trình huấn luyện và làm cho mô hình ít bị overfitting hơn.

Recurrent Neural Networks – RNN

Recurrent Neural Networks là một loại mạng nơ-ron chuyên xử lý dữ liệu tuần tự, như văn bản hoặc chuỗi thời gian, nhờ khả năng ghi nhớ thông tin từ các bước trước đó để đưa ra dự đoán.

Hidden State

Là một khái niệm cốt lõi trong Recurrent Neural Networks (RNNs), đại diện cho trạng thái bên trong của mô hình tại một thời điểm cụ thể trong chuỗi đầu vào. Nó lưu trữ thông tin ngữ cảnh từ các bước thời gian trước đó, giúp mô hình duy trì một dạng “bộ nhớ” để xử lý dữ liệu tuần tự.

Recurrent Connection

Là một thành phần cốt lõi trong Recurrent Neural Networks (RNNs), đại diện cho liên kết ngược (feedback loop) trong mạng. Nó cho phép thông tin từ các bước thời gian trước đó được truyền ngược lại vào mạng, giúp RNN duy trì “bộ nhớ” và xử lý dữ liệu tuần tự một cách hiệu quả.

Transformer Neural Networks

Transformer Neural Networks là một kiến trúc mạng nơ-ron mới, mạnh mẽ, chuyên dùng trong NLP, giúp mô hình xử lý dữ liệu song song và hiệu quả hơn, đặc biệt là trong việc dịch máy và tạo văn bản.

Self-Attention

Cơ chế cho phép mô hình tập trung vào các từ liên quan trong cùng một câu để hiểu ngữ cảnh. Trong đó Scaled Dot-Product Attention là Một phương pháp hiệu quả để tính attention giữa các vector từ và Multi-Head Attention là Kỹ thuật sử dụng nhiều “head” attention song song để mô hình hóa các ngữ cảnh khác nhau.

Positional Encoding

Là một thành phần quan trọng trong kiến trúc Transformer, được thiết kế để cung cấp thông tin về vị trí của từ trong một chuỗi dữ liệu đầu vào. Điều này cần thiết vì Transformer không có cấu trúc tuần tự như các mô hình RNN hoặc LSTM, nên bản thân nó không thể tự động nhận biết thứ tự hoặc vị trí của các từ trong chuỗi.

Masked Attention

Quá trình sử dụng một ma trận mặt nạ (mask matrix) để loại bỏ hoặc giảm trọng số của các từ không được phép nhìn thấy. Điều này đảm bảo rằng khi dự đoán từ t, chỉ các từ từ 1 đến t được phép tham gia tính toán, các từ sau t sẽ bị gán trọng số âm vô cùng trong không gian logit, dẫn đến xác suất xuất attention của chúng bằng 0.

3. Kỹ thuật học máy (Machine Learning Techniques)

Supervised Learning

Supervised Learning là phương pháp học máy trong đó mô hình được huấn luyện trên một tập dữ liệu đã gắn nhãn, nhằm dự đoán các nhãn cho dữ liệu mới.

Unsupervised Learning

Unsupervised Learning là phương pháp học máy nơi mô hình được huấn luyện trên dữ liệu chưa gắn nhãn, và nhiệm vụ của nó là tìm ra các cấu trúc ẩn hoặc mối quan hệ trong dữ liệu.

Semi-supervised Learning

Semi-supervised Learning là sự kết hợp giữa học có giám sát và không giám sát, sử dụng một lượng nhỏ dữ liệu gắn nhãn kết hợp với dữ liệu chưa gắn nhãn để cải thiện độ chính xác của mô hình.

Reinforcement Learning

Reinforcement Learning là phương pháp học máy nơi mô hình học thông qua thử và sai, nhận phần thưởng hoặc phạt từ môi trường để cải thiện hiệu suất theo thời gian.

Transfer Learning

Transfer Learning là kỹ thuật trong đó một mô hình đã được huấn luyện trên một nhiệm vụ có thể được tinh chỉnh và sử dụng lại cho một nhiệm vụ khác, giúp tiết kiệm thời gian và tài nguyên.

Deep Learning

Deep Learning là phương pháp học máy sử dụng mạng nơ-ron sâu để học từ dữ liệu lớn và phức tạp, đặc biệt hiệu quả trong xử lý hình ảnh, âm thanh, và ngôn ngữ.

Continuous Learning

Continuous Learning là khả năng của một mô hình AI để học liên tục từ dữ liệu mới, thích nghi với các thay đổi và cải thiện hiệu suất mà không cần huấn luyện lại từ đầu.

4. Các thuật toán và phương pháp (Algorithms and Methods)

Regression

Regression (Hồi quy) là một thuật toán học máy (machine learning) được sử dụng để dự đoán giá trị liên tục dựa trên các đặc trưng đầu vào. Trong hồi quy, mối quan hệ giữa biến đầu vào (features) và biến mục tiêu (target) được mô hình hóa, và mục tiêu là dự đoán một giá trị số thực từ một hoặc nhiều đặc trưng.

Classification

Classification (Phân loại) là một thuật toán học máy được sử dụng để phân nhóm hoặc phân loại các đối tượng vào các nhóm hoặc hạng mục cụ thể, dựa trên các đặc trưng đầu vào. Trong phân loại, mục tiêu là gán mỗi ví dụ dữ liệu (được mô tả bởi các đặc trưng) vào một trong các nhãn hoặc lớp đã được định nghĩa trước.

Clustering

Clustering (Phân nhóm) là một thuật toán học máy không giám sát (unsupervised learning) được sử dụng để phân loại các đối tượng hoặc dữ liệu vào các nhóm (clusters) sao cho các đối tượng trong cùng một nhóm có độ tương đồng cao, trong khi các đối tượng giữa các nhóm khác nhau có độ tương đồng thấp.

Dimensionality Reduction

Dimensionality Reduction (Giảm chiều dữ liệu) là một kỹ thuật trong học máy và khai thác dữ liệu dùng để giảm số lượng biến (features) trong một tập dữ liệu mà không làm mất quá nhiều thông tin quan trọng. Mục tiêu của kỹ thuật này là giúp giảm độ phức tạp của dữ liệu, làm cho quá trình xử lý dữ liệu và mô hình hóa trở nên nhanh chóng và hiệu quả hơn, đồng thời giúp giảm thiểu hiện tượng overfitting (mô hình quá khớp).

Decision Trees

Decision Trees (Cây quyết định) là một thuật toán học máy được sử dụng để phân loại (classification) và hồi quy (regression). Đây là một mô hình học máy giám sát (supervised learning) có thể được mô phỏng như một cây, trong đó mỗi nút (node) đại diện cho một câu hỏi về một đặc trưng (feature) của dữ liệu, và mỗi nhánh (branch) đại diện cho một kết quả của câu hỏi đó. Cuối cùng, các lá (leaf nodes) của cây chứa các quyết định hoặc dự đoán cho kết quả.

Random Forests

Random Forests (Rừng ngẫu nhiên) là một thuật toán học máy ensemble (hợp nhất) được sử dụng trong các bài toán phân loại (classification) và hồi quy (regression). Random Forests xây dựng nhiều cây quyết định (decision trees) trong quá trình huấn luyện và sử dụng kết quả từ tất cả các cây này để đưa ra dự đoán, giúp cải thiện độ chính xác và giảm hiện tượng overfitting (quá khớp) mà các cây quyết định đơn lẻ thường gặp phải.

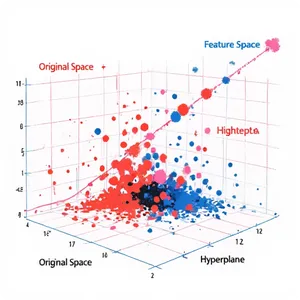

Support Vector Machines – SVM

Support Vector Machines (SVM) là một thuật toán học máy mạnh mẽ, chủ yếu được sử dụng cho các bài toán phân loại (classification) và hồi quy (regression). SVM đặc biệt nổi bật trong việc tìm ra một siêu phẳng (hyperplane) tối ưu để phân chia các lớp trong không gian đặc trưng (feature space) sao cho khoảng cách giữa các điểm dữ liệu gần nhất của các lớp khác nhau là lớn nhất.

5. Xử lý và phân tích dữ liệu (Data Processing and Analysis)

Big Data

Big Data (Dữ liệu lớn) là thuật ngữ dùng để chỉ các tập dữ liệu có kích thước và độ phức tạp vượt quá khả năng xử lý của các công cụ và phần mềm truyền thống. Những dữ liệu này thường đến từ nhiều nguồn khác nhau và có thể có một lượng khổng lồ, đa dạng, và phát triển nhanh chóng. Big Data không chỉ bao gồm dữ liệu có kích thước lớn, mà còn bao gồm các đặc điểm như tính đa dạng và tốc độ thay đổi nhanh của dữ liệu.

Data Preprocessing

Data Preprocessing (Tiền xử lý dữ liệu) là quá trình chuẩn bị và làm sạch dữ liệu thô để có thể sử dụng hiệu quả trong các mô hình học máy (machine learning) hoặc phân tích dữ liệu. Dữ liệu thô có thể chứa nhiều vấn đề như thiếu sót, nhiễu, hoặc không đồng nhất, vì vậy quá trình tiền xử lý giúp cải thiện chất lượng của dữ liệu, từ đó giúp nâng cao độ chính xác và hiệu quả của mô hình.

Data Augmentation

Data Augmentation (Tăng cường dữ liệu) là một kỹ thuật trong học máy và học sâu (deep learning) dùng để mở rộng và cải thiện bộ dữ liệu huấn luyện bằng cách tạo ra các biến thể mới từ các dữ liệu gốc mà không cần phải thu thập thêm dữ liệu mới. Quá trình này giúp mô hình học được nhiều đặc điểm hơn, từ đó tăng khả năng tổng quát và giảm hiện tượng overfitting (mô hình quá khớp với dữ liệu huấn luyện).

Data Mining

Data Mining là quá trình khai thác thông tin hữu ích từ một lượng lớn dữ liệu bằng cách sử dụng các kỹ thuật thống kê, học máy, và phân tích dữ liệu. Mục tiêu của data mining là tìm ra các mẫu, mối quan hệ, hoặc thông tin tiềm ẩn trong dữ liệu, giúp đưa ra các quyết định kinh doanh, dự đoán, hoặc phát hiện các xu hướng.

Predictive Analytics

Predictive Analytics (Phân tích dự đoán) là một nhánh của phân tích dữ liệu dùng các phương pháp thống kê, học máy, và các thuật toán để phân tích dữ liệu hiện có và dự đoán các xu hướng, sự kiện hoặc hành vi trong tương lai. Mục tiêu của predictive analytics là sử dụng dữ liệu quá khứ để đưa ra các dự đoán về những gì có thể xảy ra trong tương lai, giúp doanh nghiệp và tổ chức ra quyết định hiệu quả hơn.

Data Visualization

Data Visualization (Trực quan hóa dữ liệu) là quá trình sử dụng các đồ họa, biểu đồ và các hình thức trực quan khác để biểu diễn dữ liệu. Mục tiêu của data visualization là giúp người dùng hiểu và phân tích dữ liệu một cách dễ dàng và trực quan, từ đó hỗ trợ việc ra quyết định chính xác hơn.

Structured and Unstructured Data

Structured and Unstructured Data là dữ liệu được tổ chức dưới dạng bảng với các hàng và cột, dễ dàng xử lý bằng các hệ thống cơ sở dữ liệu truyền thống. Dữ liệu phi cấu trúc, ngược lại, không theo một cấu trúc cố định, bao gồm văn bản, hình ảnh, video và yêu cầu các kỹ thuật đặc biệt để xử lý.

6. Đánh giá và tối ưu hóa mô hình (Model Evaluation and Optimization)

Accuracy

Accuracy (Độ chính xác) là một chỉ số dùng để đo lường hiệu quả của một mô hình học máy, đặc biệt trong các bài toán phân loại. Độ chính xác được tính bằng tỷ lệ giữa số lượng dự đoán đúng so với tổng số dự đoán mà mô hình thực hiện.

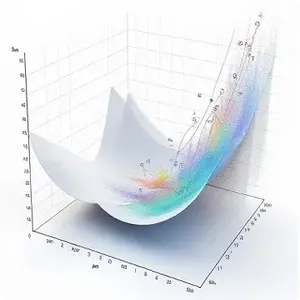

Loss Function

Loss Function (Hàm mất mát) là một hàm toán học dùng để đo lường mức độ sai lệch hoặc độ chính xác của dự đoán so với giá trị thực tế trong một mô hình học máy. Nó giúp mô hình “hiểu” được sự khác biệt giữa các giá trị dự đoán và giá trị thật, từ đó có thể điều chỉnh các tham số của mô hình để cải thiện hiệu quả dự đoán trong quá trình huấn luyện. Mục tiêu của việc sử dụng loss function là tối thiểu hóa giá trị hàm mất mát trong quá trình huấn luyện, giúp mô hình dự đoán chính xác hơn.

Overfitting

Overfitting (Quá khớp) là hiện tượng khi một mô hình học máy học quá chi tiết các đặc điểm của dữ liệu huấn luyện, đến mức mô hình “học” những nhiễu (noise) và sự biến động không có ý nghĩa, thay vì chỉ học được các mẫu và xu hướng chung trong dữ liệu. Khi xảy ra overfitting, mô hình có thể đạt được độ chính xác rất cao trên tập huấn luyện, nhưng lại hoạt động kém trên các dữ liệu chưa thấy (dữ liệu kiểm tra hoặc dữ liệu thực tế), vì nó không thể tổng quát tốt.

Underfitting

Underfitting (Thiếu khớp) là hiện tượng khi một mô hình học máy không đủ khả năng học được các mẫu và xu hướng trong dữ liệu huấn luyện, dẫn đến việc mô hình không thể dự đoán chính xác ngay cả trên dữ liệu huấn luyện, chứ đừng nói đến dữ liệu mới. Khi một mô hình bị underfit, nó không đủ phức tạp để mô tả các mối quan hệ trong dữ liệu, khiến hiệu suất của mô hình thấp ở cả tập huấn luyện và tập kiểm tra.

Cross-validation

Cross-validation (Kiểm tra chéo) là một kỹ thuật được sử dụng trong học máy để đánh giá khả năng tổng quát của một mô hình trên một tập dữ liệu chưa được sử dụng trong quá trình huấn luyện. Nó giúp kiểm tra độ chính xác và tính ổn định của mô hình khi áp dụng vào các dữ liệu khác nhau, tránh tình trạng mô hình bị overfitting hoặc underfitting.

Hyperparameter Optimization

Hyperparameter Optimization (Tối ưu hóa siêu tham số) là quá trình tìm kiếm các giá trị tối ưu cho các siêu tham số trong mô hình học máy để cải thiện hiệu suất của mô hình. Các siêu tham số là các tham số được xác định trước khi huấn luyện mô hình và không được điều chỉnh trong quá trình học, khác với các tham số của mô hình (như trọng số trong mạng nơ-ron).

Precision, Recall, and F1 Score

Precision đo lường tỷ lệ dự đoán đúng trong số các dự đoán mà mô hình đã xác định là dương tính.

Recall đo lường khả năng của mô hình trong việc tìm ra tất cả các trường hợp dương tính thực sự.

F1 Score là trung bình điều hòa giữa độ chính xác và độ thu hồi, cung cấp một thước đo cân bằng giữa hai chỉ số này.